|

|

|

|

@ -1,5 +1,4 @@

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

<p align="center">

|

|

|

|

|

<a href="#"><img src="https://img.shields.io/badge/Author-3y-orange.svg" alt="作者"></a>

|

|

|

|

|

<a href="#项目官方交流群"><img src="https://img.shields.io/badge/项目群-交流-red.svg" alt="项目群交流"></a>

|

|

|

|

|

@ -44,35 +43,35 @@

|

|

|

|

|

|

|

|

|

|

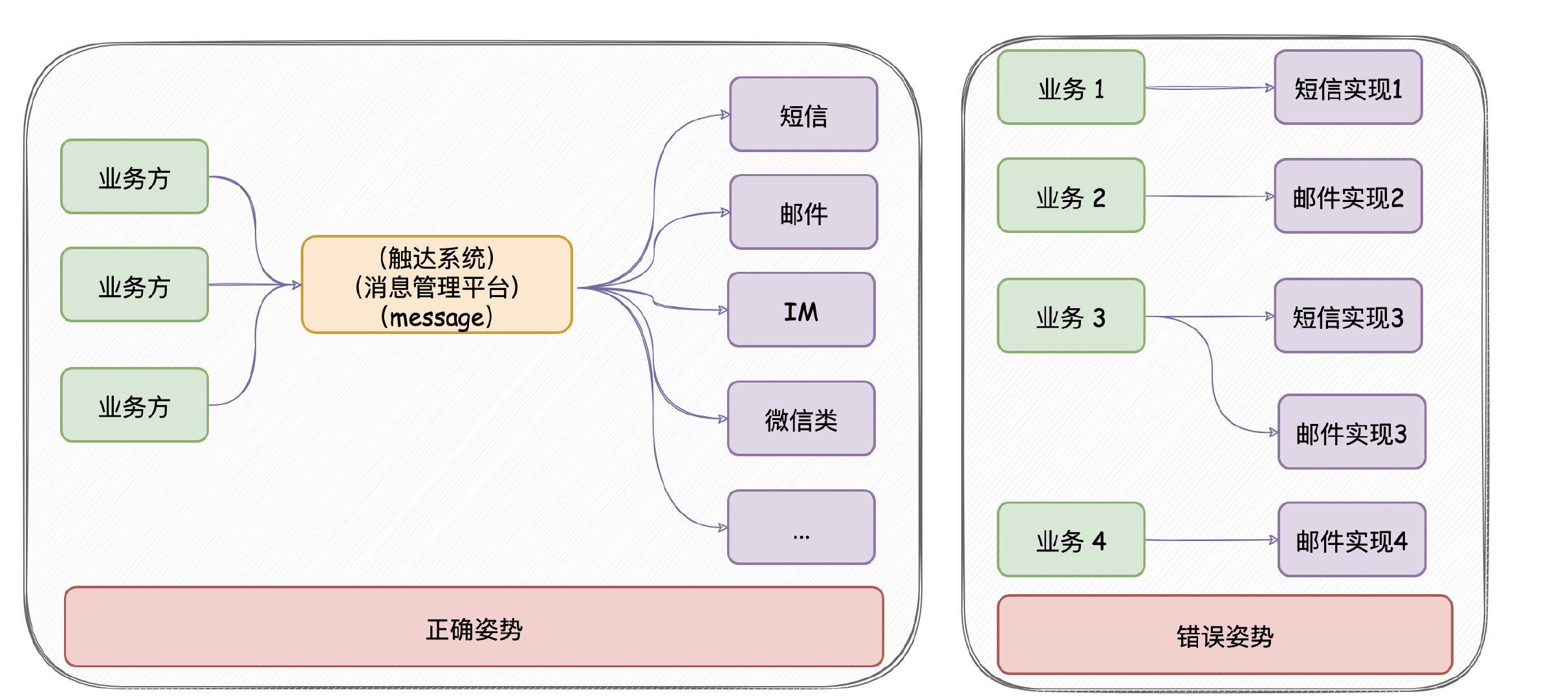

**意义**:只要公司内部有发送消息的需求,都应该要有类似`austin`的项目。消息推送平台对各类消息进行统一发送处理,这有利于对功能的收拢,以及提高业务需求开发的效率。

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

## 使用姿势

|

|

|

|

|

|

|

|

|

|

**1**、创建需要发送的渠道账号

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

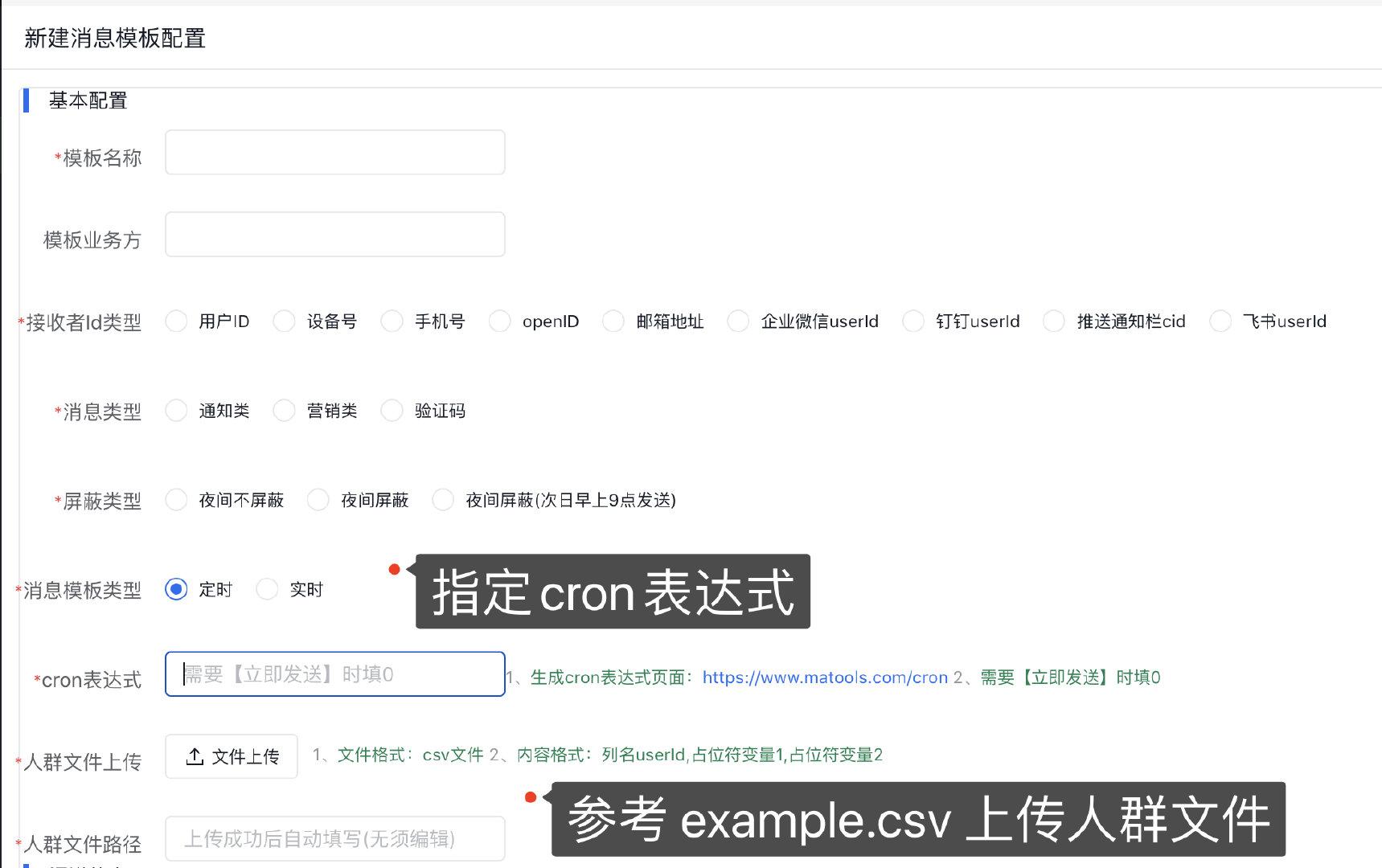

**2**、创建消息模板

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

**3**、测试发送消息是否正常

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

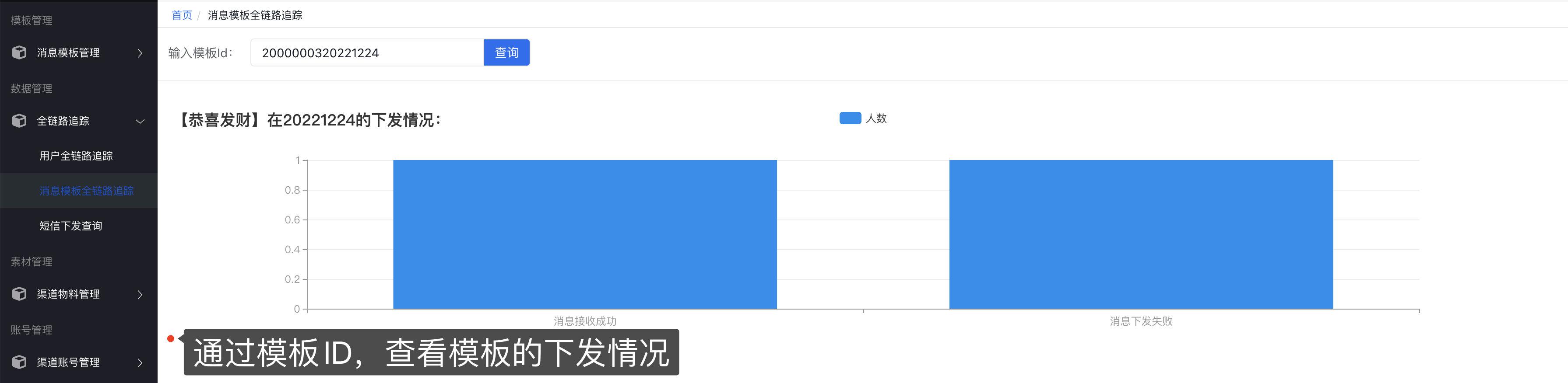

**4**、查看消息下发情况

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

**5**、亦可在新建模板时选择**定时任务**,通过上传[csv文件](https://www.yuque.com/office/yuque/0/2022/csv/1285871/1671865125068-b5385387-b4a4-41ac-a43e-bab54ee49d88.csv?from=https%3A%2F%2Fwww.yuque.com%2Fu1047901%2Fniffsu%2Fqqtese%2Fedit)和指定cron表达式实现下发消息

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

## 部署姿势

|

|

|

|

|

|

|

|

|

|

austin项目**强依赖**`MySQL`/`Redis`/(**大概需要2G内存**),**弱依赖**`kafka`/`prometheus`/`graylog`/`flink`/`xxl-job`/`apollo`/`hive`(**完全部署所有的服务,大概16G内存**)。如果缺少相关的组件可戳:[安装相关组件教程](INSTALL.md)。

|

|

|

|

|

austin项目**强依赖**`MySQL`/`Redis`/(**大概需要2G内存**),**弱依赖**`kafka`/`prometheus`/`graylog`/`flink`/`xxl-job`/`apollo`/`hive`(**完全部署所有的服务,大概16G内存**)。如果缺少相关的组件可戳:[安装相关组件教程](doc/INSTALL.md)。

|

|

|

|

|

|

|

|

|

|

> 实在想要`clone`项目后不用自己部署环境直接在**本地**启动`debug`,我这提供了[股东服务](https://www.yuque.com/u1047901/eg5qvy/hh0gk5p4uwie8bva),**直连**部署好的服务器。

|

|

|

|

|

|

|

|

|

|

@ -80,7 +79,7 @@ austin项目**强依赖**`MySQL`/`Redis`/(**大概需要2G内存**),**弱依

|

|

|

|

|

|

|

|

|

|

**2**、填写`application.properties`中`spring.datasource`对应的`ip/port/username/password`信息

|

|

|

|

|

|

|

|

|

|

**3**、执行`sql`文件夹下的`austin.sql`创建对应的表

|

|

|

|

|

**3**、执行`doc/sql`文件夹下的[austin.sql](doc/sql/austin.sql)创建对应的表

|

|

|

|

|

|

|

|

|

|

**4**、填写`application.properties`中`spring.redis`对应的`ip`/`port`/`password`信息

|

|

|

|

|

|

|

|

|

|

@ -88,24 +87,24 @@ austin项目**强依赖**`MySQL`/`Redis`/(**大概需要2G内存**),**弱依

|

|

|

|

|

|

|

|

|

|

**6**、**austin前端管理系统部署**,戳[GitHub](https://github.com/ZhongFuCheng3y/austin-admin)或[Gitee](https://gitee.com/zhongfucheng/austin-admin)跳转至对应的仓库

|

|

|

|

|

|

|

|

|

|

**7**、(可选)正常使用**数据管理**(查看实时数据链路下发)需要将`austin-stream`的`jar`包上传至`Flink`,根据[部署文档](INSTALL.md)启动Flink。在打`jar`包前需要填写`com.java3y.austin.stream.constants.AustinFlinkConstant`中的`redis`和`kafka`的`ip/port`(注意:日志的topic在`application.properties`中的`austin.business.log.topic.name`。如果没有该topic,需要提前创建,并**使用Kafka**作为消息队列实现)

|

|

|

|

|

**7**、(可选)正常使用**数据管理**(查看实时数据链路下发)需要将`austin-stream`的`jar`包上传至`Flink`,根据[部署文档](doc/INSTALL.md)启动Flink。在打`jar`包前需要填写`com.java3y.austin.stream.constants.AustinFlinkConstant`中的`redis`和`kafka`的`ip/port`(注意:日志的topic在`application.properties`中的`austin.business.log.topic.name`。如果没有该topic,需要提前创建,并**使用Kafka**作为消息队列实现)

|

|

|

|

|

|

|

|

|

|

**8**、(可选)正常使用**定时任务**需要部署`xxl-job`,根据[部署文档](INSTALL.md)启动xxl的调度中心,并在`application.properteis`中填写 `austin.xxl.job.ip`和`austin.xxl.job.port`

|

|

|

|

|

**8**、(可选)正常使用**定时任务**需要部署`xxl-job`,根据[部署文档](doc/INSTALL.md)启动xxl的调度中心,并在`application.properteis`中填写 `austin.xxl.job.ip`和`austin.xxl.job.port`

|

|

|

|

|

|

|

|

|

|

**9**、(可选)正常使用**分布式日志采集**需要部署`graylog`,根据[部署文档](INSTALL.md)启动`graylog`,并在`application.properteis`中填写 `austin.graylog.ip`。

|

|

|

|

|

**9**、(可选)正常使用**分布式日志采集**需要部署`graylog`,根据[部署文档](doc/INSTALL.md)启动`graylog`,并在`application.properteis`中填写 `austin.graylog.ip`。

|

|

|

|

|

|

|

|

|

|

**10**、(可选)正常使用**系统监控**需要部署`promethus`和`grafana`,根据[部署文档](INSTALL.md)配置`grafana`图表。

|

|

|

|

|

**10**、(可选)正常使用**系统监控**需要部署`promethus`和`grafana`,根据[部署文档](doc/INSTALL.md)配置`grafana`图表。

|

|

|

|

|

|

|

|

|

|

**11**、(可选)正常使用**动态配置中心**需要部署`apollo`,根据[部署文档](INSTALL.md)启动`apollo`,通过docker-compose启动需要在AustinApplication注入对应的ip和port(可看注释)。

|

|

|

|

|

**11**、(可选)正常使用**动态配置中心**需要部署`apollo`,根据[部署文档](doc/INSTALL.md)启动`apollo`,通过docker-compose启动需要在AustinApplication注入对应的ip和port(可看注释)。

|

|

|

|

|

|

|

|

|

|

**12**、(可选)正常使用**数据仓库**需要部署`hive`,根据[部署文档](INSTALL.md)通过`flink`把数据写入到`hive`中(`flink`环境也要安装好),将`austin-data-house`的`jar`包提交到`flink`执行

|

|

|

|

|

**12**、(可选)正常使用**数据仓库**需要部署`hive`,根据[部署文档](doc/INSTALL.md)通过`flink`把数据写入到`hive`中(`flink`环境也要安装好),将`austin-data-house`的`jar`包提交到`flink`执行

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

## 官方项目交流群

|

|

|

|

|

|

|

|

|

|

austin项目官方交流群已经超过了两百人,添加我的个人微信 java3yyy 添加时备注:【**项目**】,我空的时候会拉进项目交流群里。

|

|

|

|

|

|

|

|

|

|

<img align="center" src='https://p1-juejin.byteimg.com/tos-cn-i-k3u1fbpfcp/db4e126ed8d3400983f70c4c5f73cb0a~tplv-k3u1fbpfcp-watermark.image?' width=300px height=300px />

|

|

|

|

|

<img align="center" src='doc/images/8.png' width=300px height=300px />

|

|

|

|

|

|

|

|

|

|

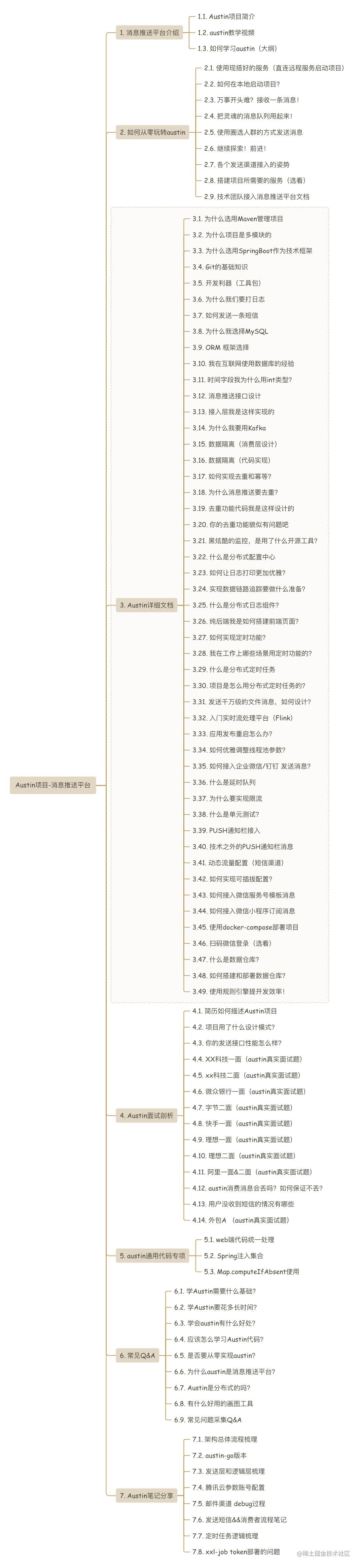

## 项目文档

|

|

|

|

|

|

|

|

|

|

@ -113,4 +112,4 @@ austin项目官方交流群已经超过了两百人,添加我的个人微信 j

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|